2025年8月13日 南大仙林校区 众创空间路演大厅

2025年优秀中学生南京大学一流学科专题营(第28期) 大数据与人工智能方向 课程内容

申富饶教授 南京大学人工智能学院

此处应有文章链接。

前言

一开始是因为录音听不见,所以笔记从头到尾都比较详细;课程中发现教授把神经网络讲得透彻,有很大收获,于是这节课被单独拿出来记录。

希望大家读完这篇文章能对各类神经网络有个感性认识。

笔者是一个完全不懂神经网络的小白。笔记是经过自己理解的二手材料,所以请不要把这篇文章用于学习,当个消遣就好。如果以后我学习人工智能专业,再回来看这篇文章,应该会笑话我自己吧。

一、从人类大脑到机器大脑

研究人工智能的学者是唯物的。他们认为,意识与物质是一体的,这是研究神经网络的基础。

人类大脑的特点

人的智能来源于大脑。大脑:1kg+,占1.7%质量,消耗20%能量。

人类进化方向:修炼大脑。

人类大脑如何工作

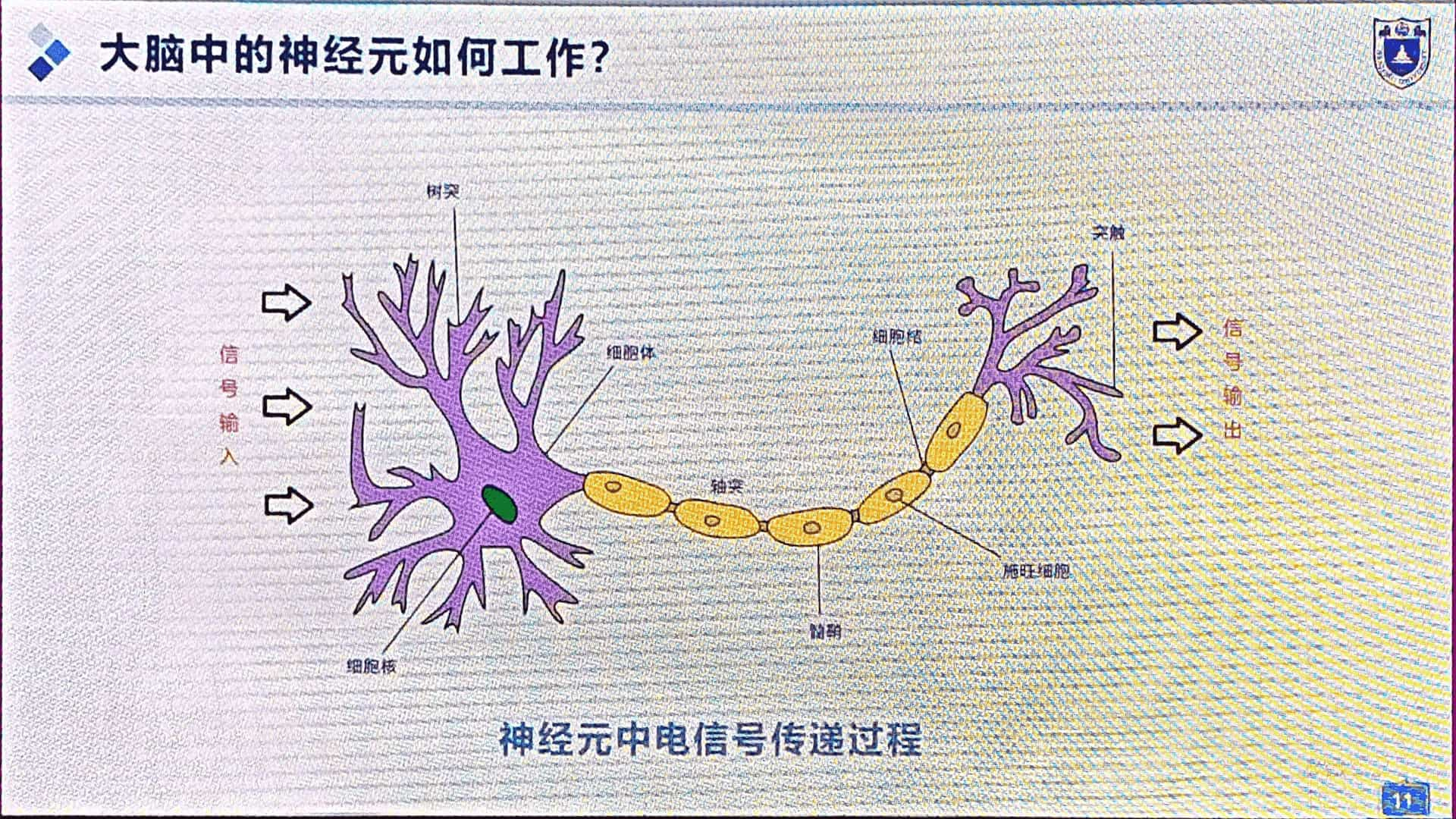

基本组成单位神经元,神经元组织成神经网络。

神经元传递神经递质和电信号。

树突输入,细胞体处理,轴突输出。神经元连接处叫突触。(图2、图3)

人大脑分区,分工协作。

人为什么比其它动物聪明?前额叶多了一些灰质。

人的智能程度取决于:①神经元数量;②神经元连接数量。

知识储存于连接中。神经越粗,连接越强,越容易触发响应;越细越不容易响应。

有的敏感,有的迟钝,差异化的激活阈值是智慧的起源。

神经连接案例:熟练钢琴家并指,FTSD。

局灶性任务特异性肌张力障碍(FTSD)是一种运动障碍,在过度熟练的钢琴家身上表现为演奏时手指不自主并拢(并指)。这源于大脑基底神经节和运动皮层神经元异常同步放电:原本应独立控制的神经信号紊乱同步,导致手指屈肌群过度同步收缩,而伸肌群抑制,从而形成肌肉张力异常和并指现象。

二、典型神经网络及其应用

人工智能领域,起源在现代,不去古代挖“木牛流马”。

概览:(图55,总结)

MP 神经元 → 神经网络

CNN → CNN+RNN

RNN

RNN+CNN → GAN → 扩散模型

RNN → Transformer

第一张人工神经网络

第一步:通过人工神经元模仿生物神经元

神经科学家 Warren McCulloch & 数学家 Walter Pitts 构建 MP 神经元。

MP 神经元的结构。(图4)

$x^1,\ x^2,\ \dots,\ x^m$ 作为输入,$w^1,\ w^2,\ \dots,\ w^m$ 是权重,$\Sigma$ 和 $\text{Activation Function}$ 负责阈值激活。

权重表述连接,反映网络强弱;阈值激活模拟神经元细胞体工作。

1. 什么是参数?

用于确定一个神经网络,全部神经元权重 $w_i$ 的数量。

2. 怎么求得参数:设计还是学习?

最开始的 MP 神经元人为指定权重 $w_i$,现在由训练学习得到。

3. 数据从何而来?

没认真听课,不过后面每一个案例都有讲到。

4. 什么是激活函数?

MP神经元中是个“台阶”,超过阈值激活。

变体:①和 $\Sigma$ 换成积 $\Pi$;②不同的激活函数(图5);……。

第二步:连接人工神经元组成人工智能网络

经典构型(图6):$x_1,\ x_2,\ \dots,\ x_n$ 作为输入层(黄色标记),$y_1,\ y_2,\ \dots,\ y_n$ 作为输出层(橙色标记),剩余神经元作为隐藏层(蓝色标记)。

层间全连接(两两连接),同层不连接。

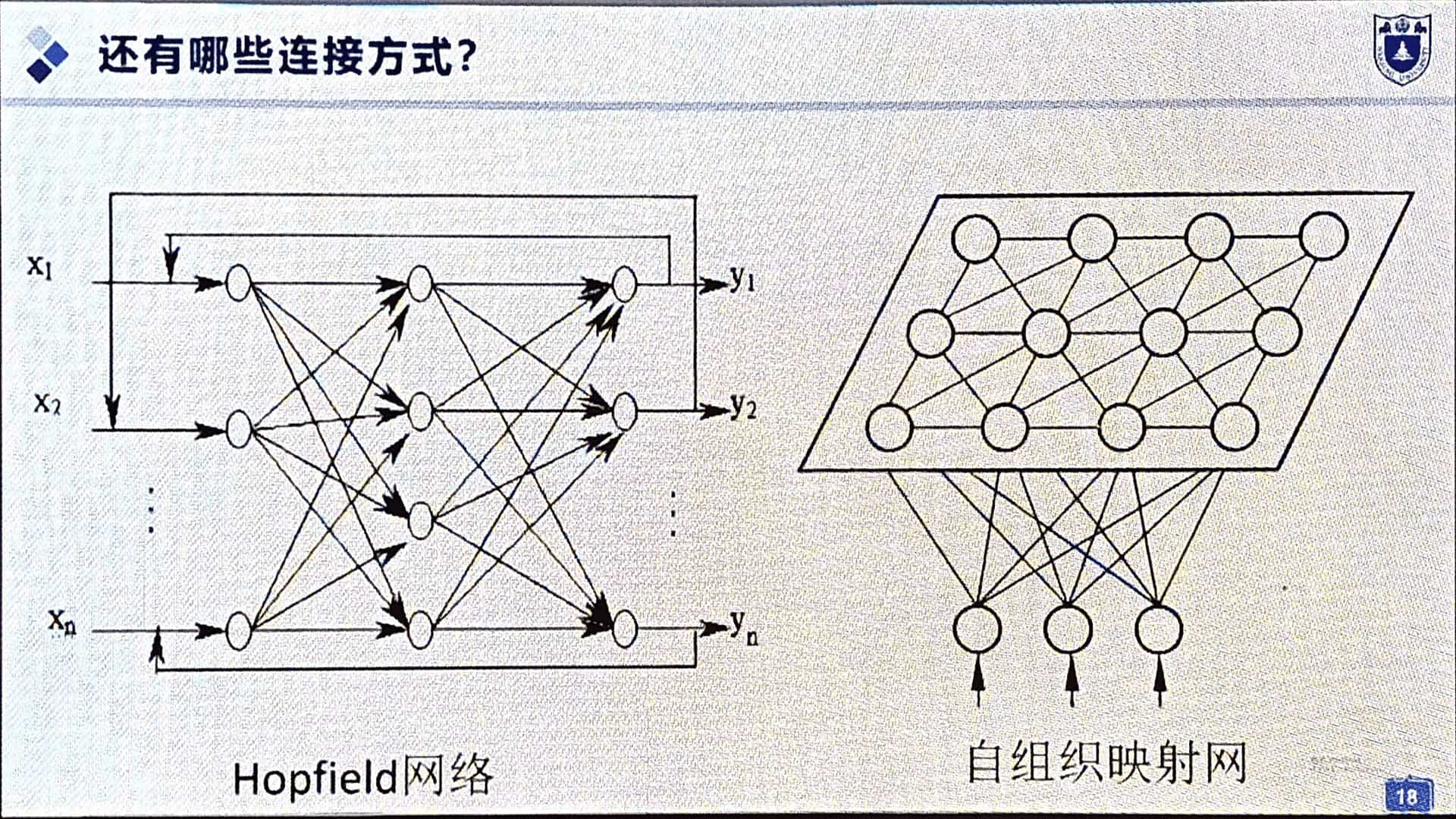

Hopfield 网络:反馈连接、联想记忆。

自组织映射网:更像人类大脑,根据外界数据自行连接,而非强行连接。(图7)

第三步:人工智能网络的学习

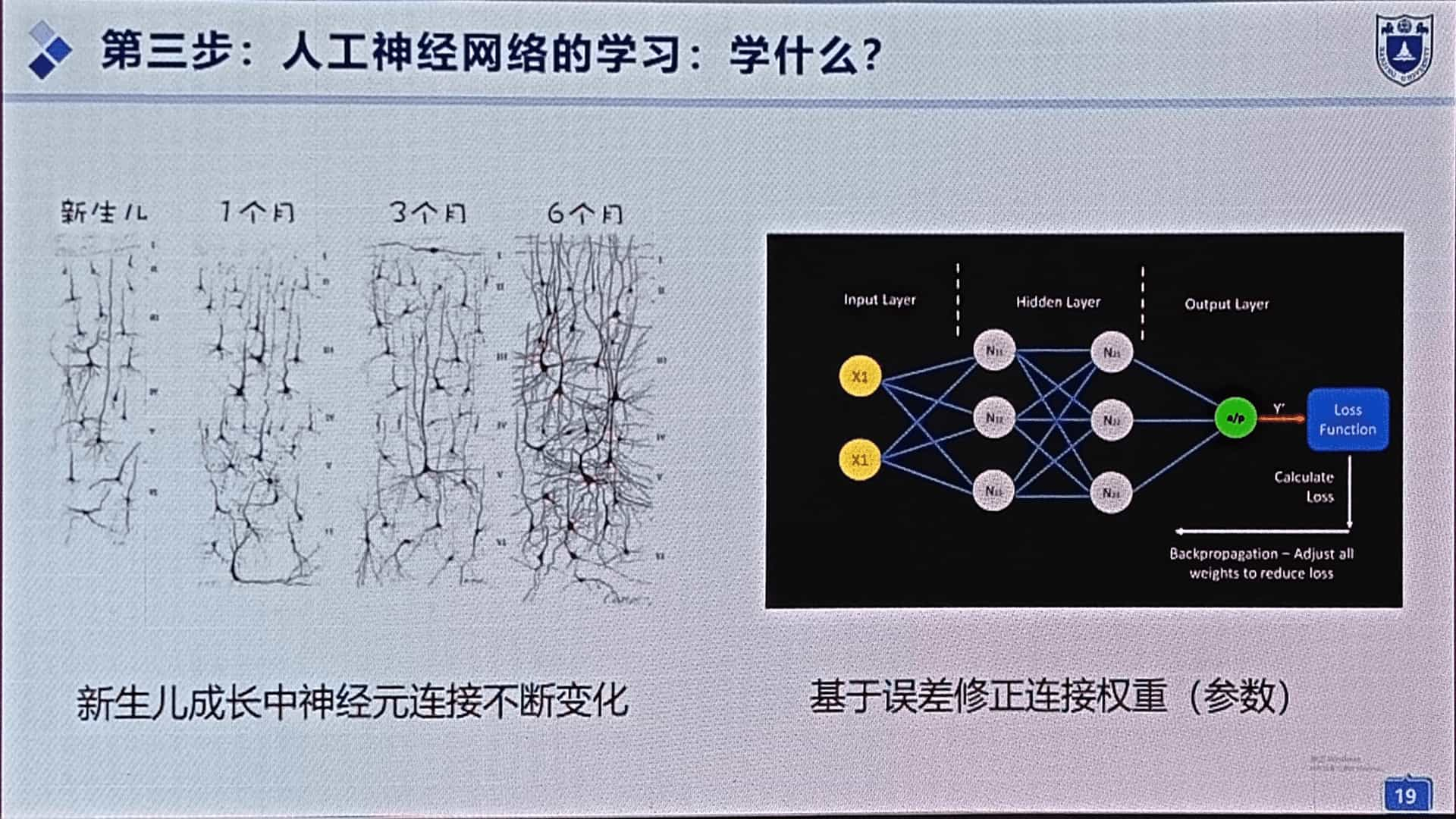

新生儿成长中,神经元彼此建立连接。

但对于一般的人工神经网络,学习过程只更改权重 $w_i$(即参数)。(图8)

还有前反馈神经网络,根据误差修正参数。

第四步:训练好的神经网络部署到实际应用

没认真听课。

自动驾驶:机器视觉

自动驾驶的背后是什么?机器大脑的视觉。如何实现机器视觉?

1. 研究生物大脑的视觉机制

Torsten Wiesel 和 David Hubel,一个生物学家,另一个忘了。研究猫的大脑,发现分层机制。

视网膜接收像素 → V1 层检测边缘 → V2 层原始形状检测 → V4 层高层次视觉抽象

像素 → 边界 → 细节 → 整体印象(图9)

人理解世界的方法:多层抽象、化繁为简。(图10)

九步剪纸还原雪花,层层理解复合函数。(图11)

2. 设计多层抽象思维的机器大脑

深度学习:每一层做简单的事。模拟人类,多层抽象,化繁为简。

在机器视觉中,单层/浅层学习依赖人工设计特征进行图像分类或检测,模型结构简单(通常1-2层)。

深度学习使用多层神经网络自动从原始像素中逐层学习特征(低级边缘→高级语义),模型结构更深(数层至数百层)。

核心区别在于特征提取方式:浅层学习需手动特征工程,能力有限;深度学习自动学习分层特征表示,能处理更复杂模式,性能通常更优。

CNN 卷积神经网络:

输入 → 卷积层读取特征 → 池化层细节重组 → 全连接层识别目标(图13-15)

特征学习、特征表述。上一层的输出作为下一层神经网络的输入。

3. 应用

(a) 图像分类;(b) 目标检测;(c) 语义分割;(d) 实例分割。(图17)

进阶应用:智能驾驶。

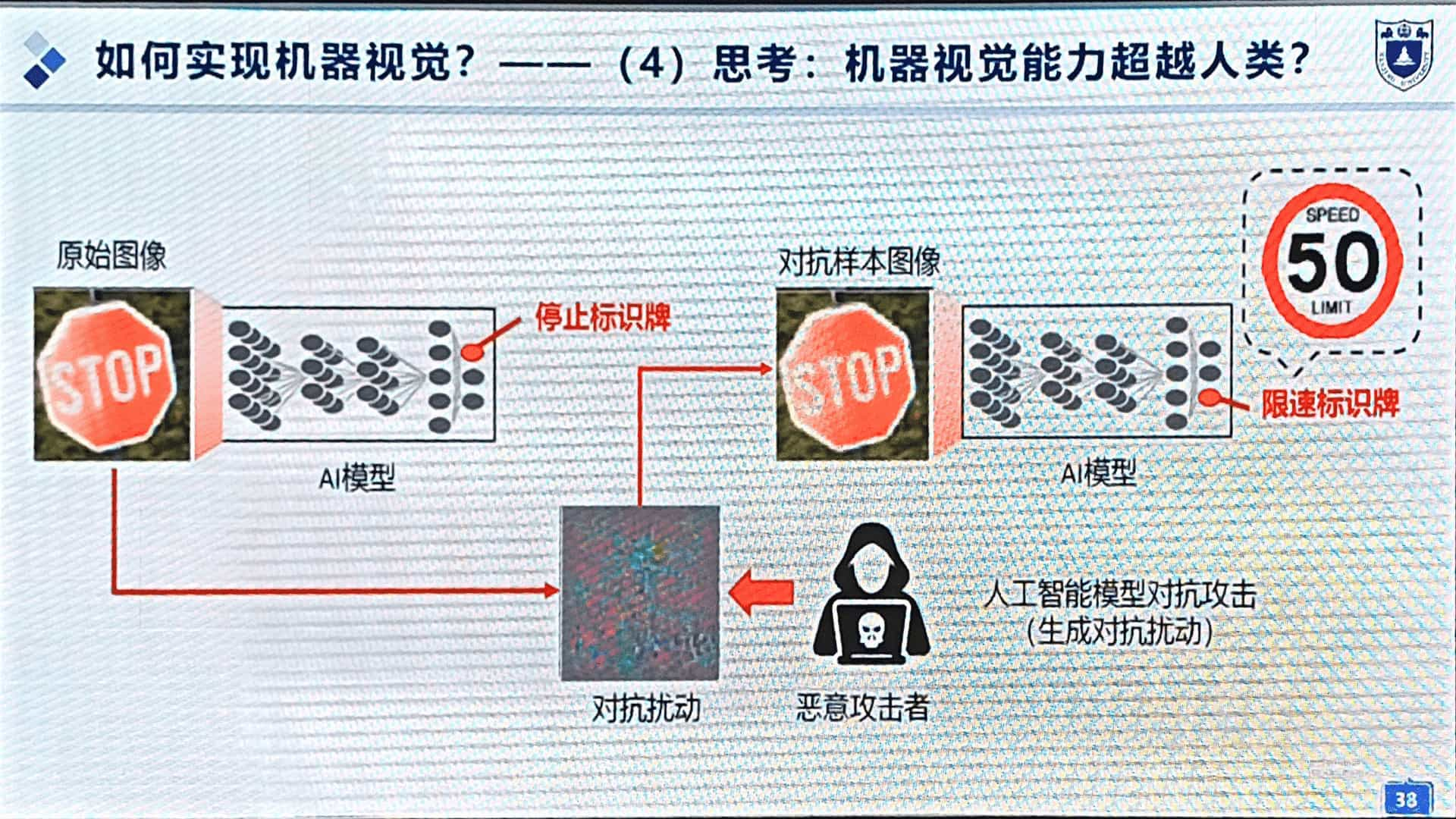

4. 思考:机器视觉能力超越人类?

神经网络可以被攻击,产生相反的识别结果。攻击手段分电子、物理两类。(图18)

自动写作:机器记忆

机器大脑的记忆和理解能力。

1. 研究生物大脑的记忆机制

分短期记忆/长期记忆。

例:高考阅读理解题,结合文章内容 / 结合社会生活中……。

2. 设计具有记忆能力的机器大脑

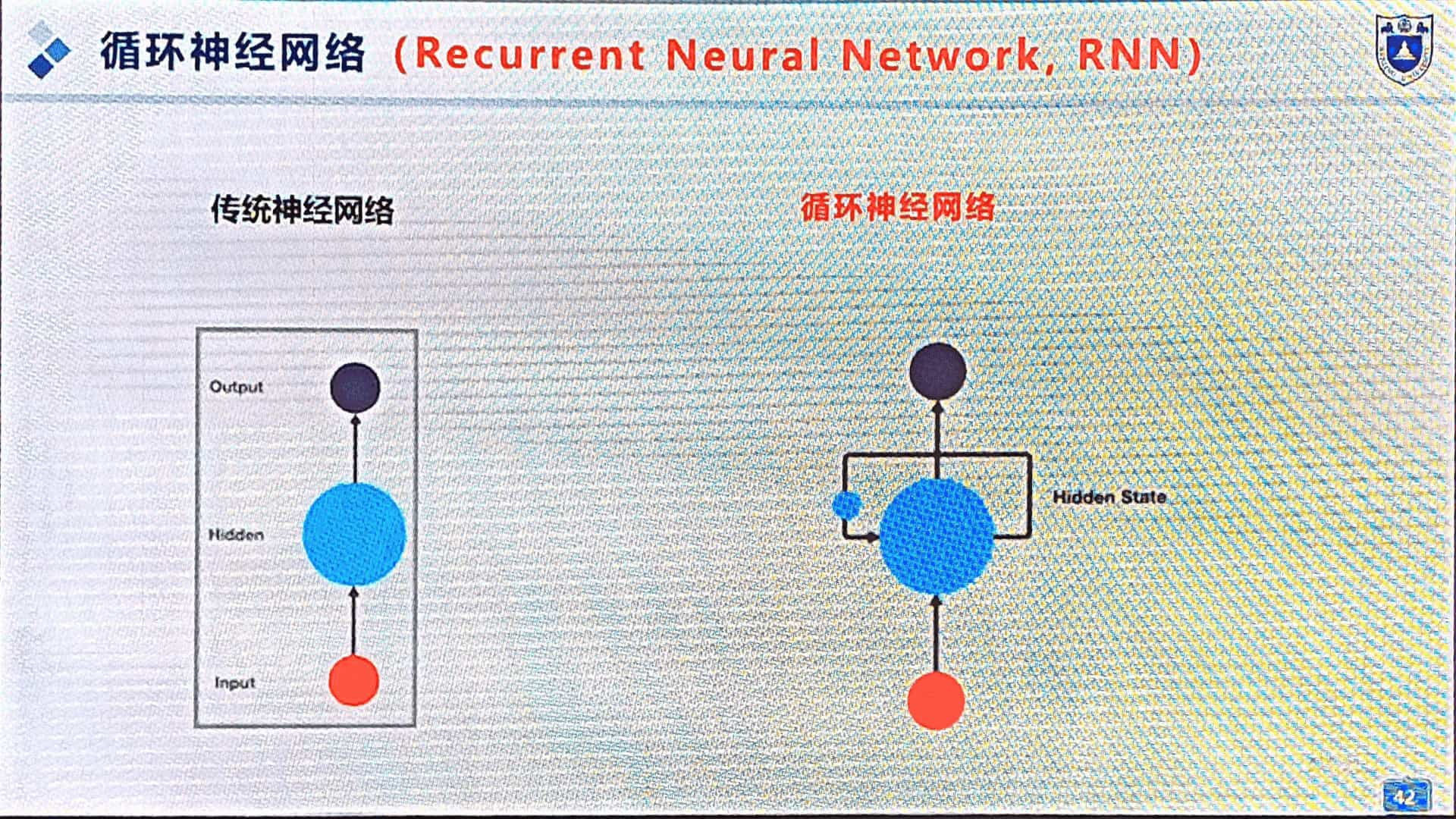

RNN 循环神经网络,擅长处理序列(与时间相关)。(图20、图21)

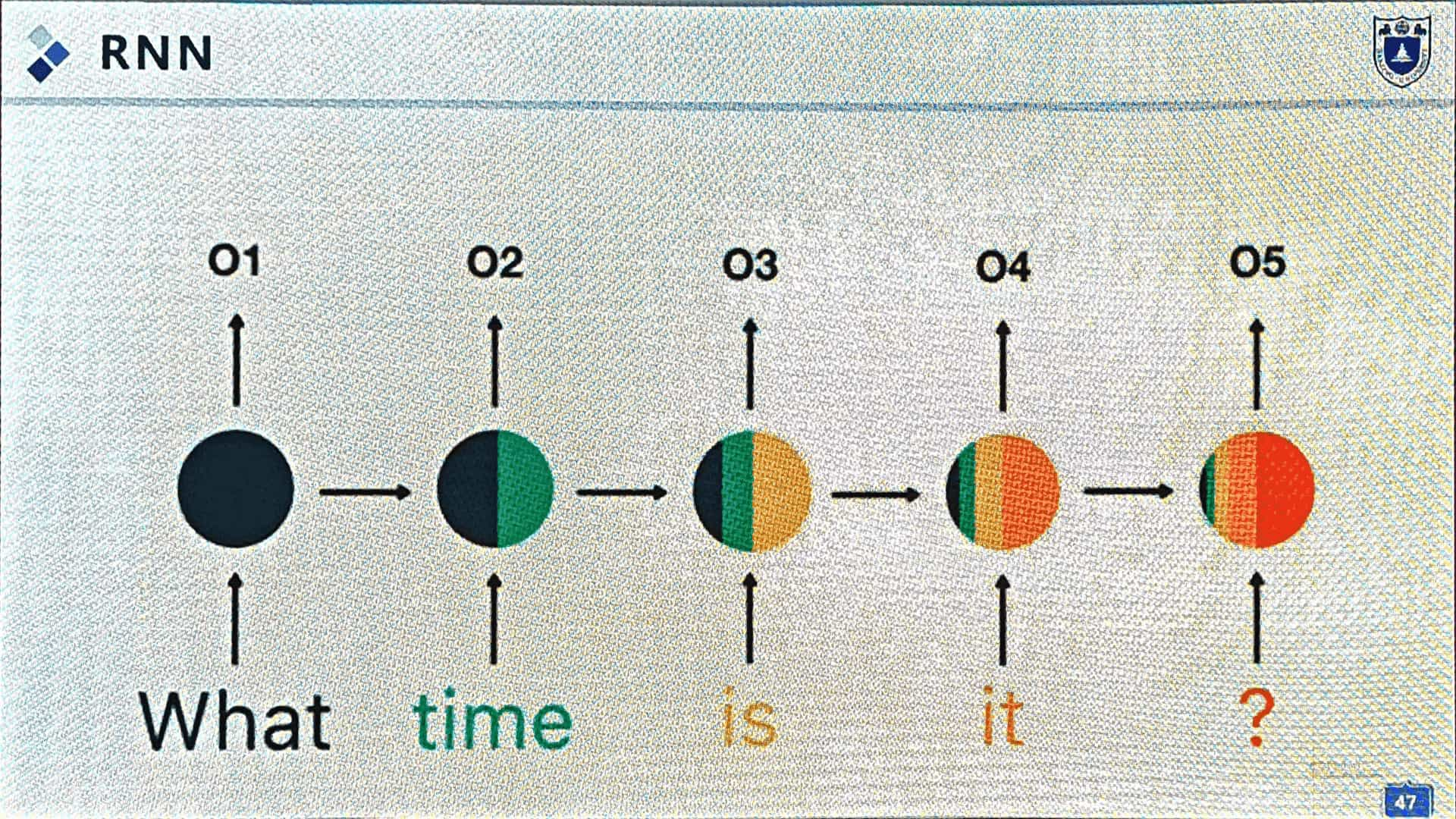

例:处理文本序列:“What time is it?”

分词,每个词顺序进入 RNN。(图22)

循环的神经网络使得每个词都有信息保留,短期记忆将其串联成句,具备理解能力。

“Asking for time.”

3. 应用

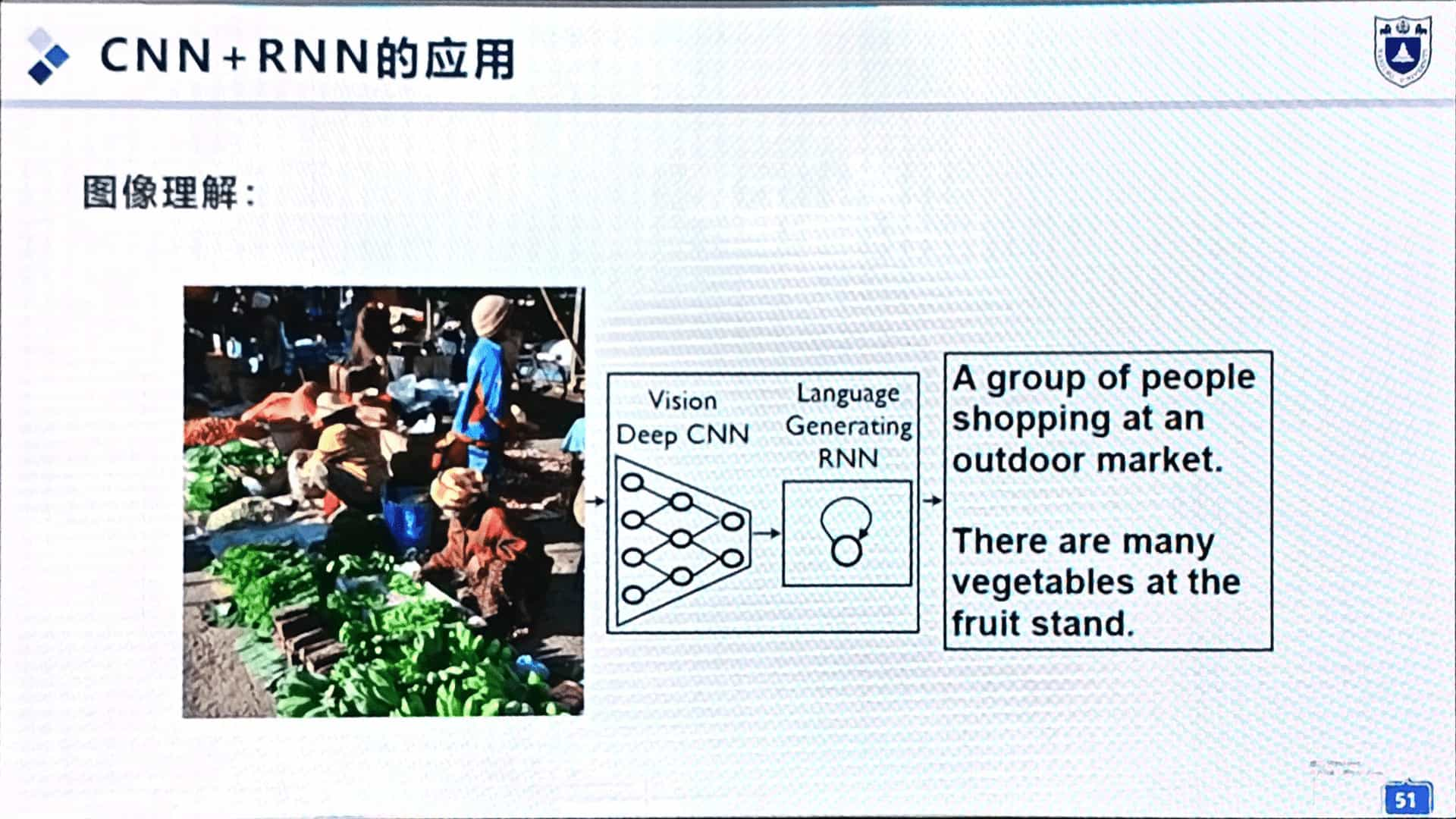

文本生成(图23)、语音降噪、图像理解(CNN+RNN,图24)。

4. 机器记忆和人类记忆一样吗?

短期记忆:越靠前的信息遗忘的越多(图22)。RNN 只具备短期记忆;人类具备长期记忆,可以想起来小时候的事情。

注意力:乱吃一通没有重点,句子远端词语无法关联。(图25)

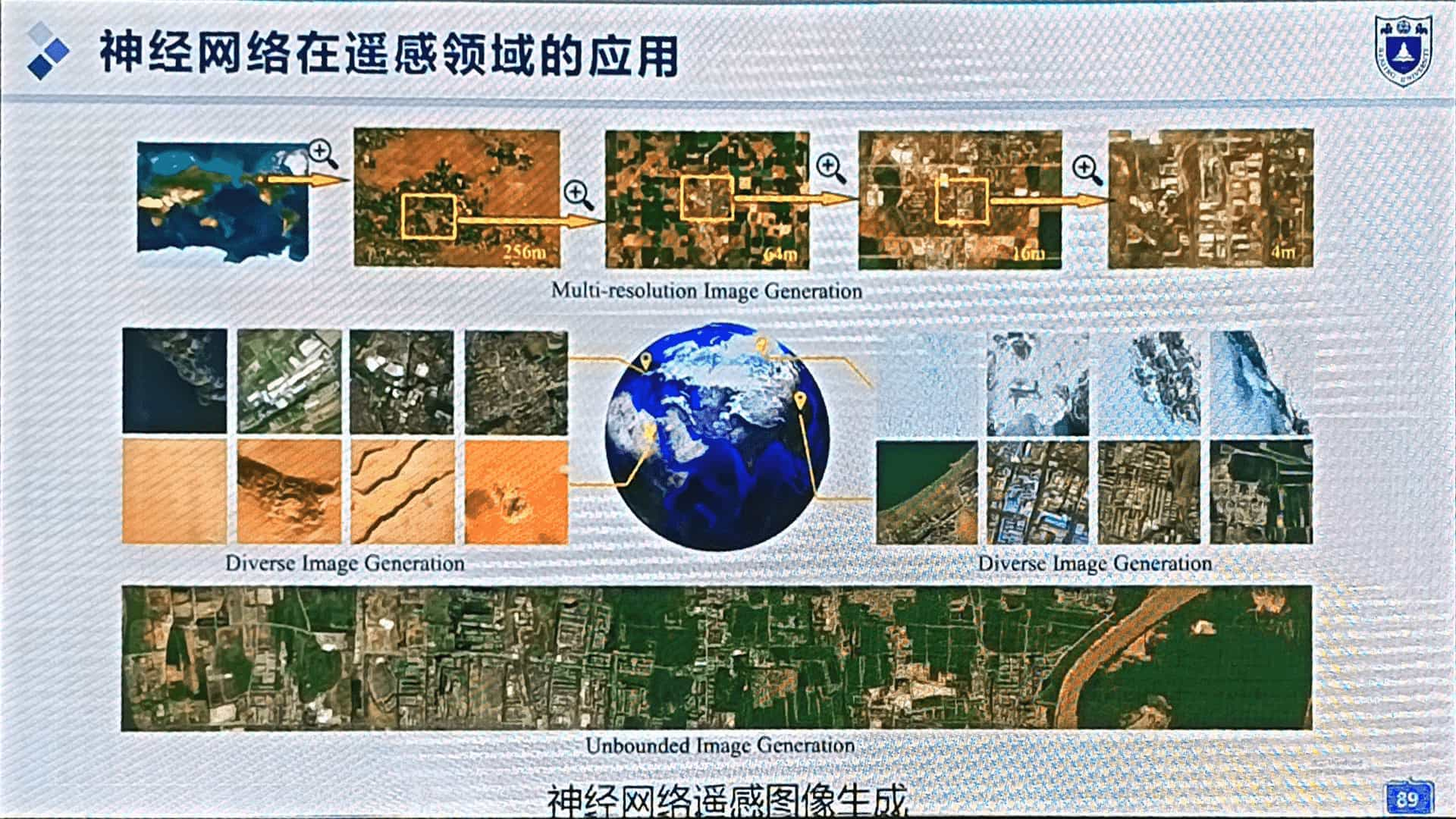

图像生成:机器创造

图像生成的背后是什么?机器大脑的创造力。如何实现机器创造?

1. 人类大脑的创造力从何而来

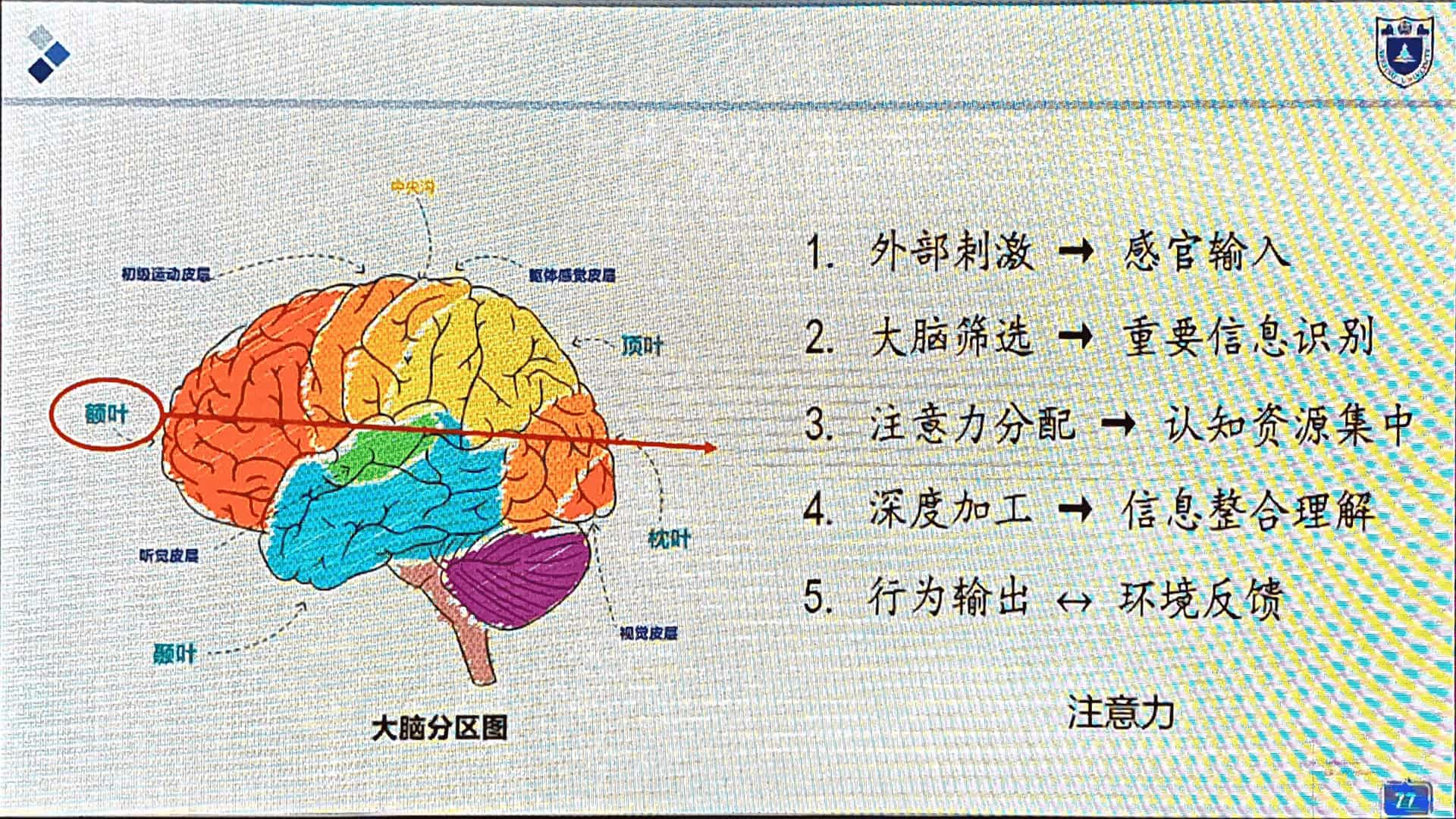

来自大脑各分区的协同。额叶、颞叶、顶叶协同。

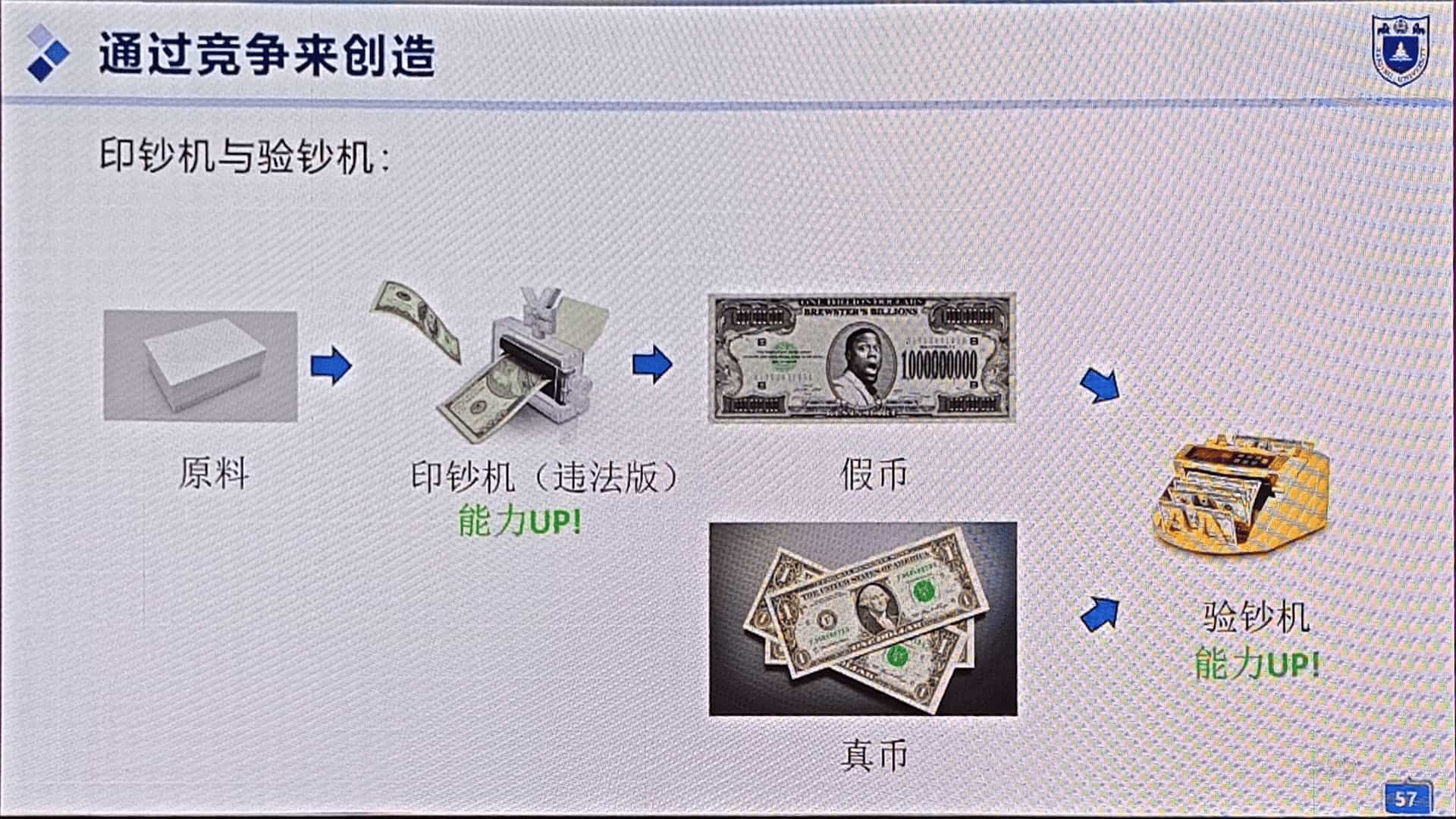

观点:创造力来自竞争

1. 商业,新产品的差异化定位。

2. 伪钞/验钞机,双方竞争过程中,技术不断精进,直到人眼彻底无法分辨。(图27)

2. 设计具有创造力的机器大脑

通过竞争来创造。

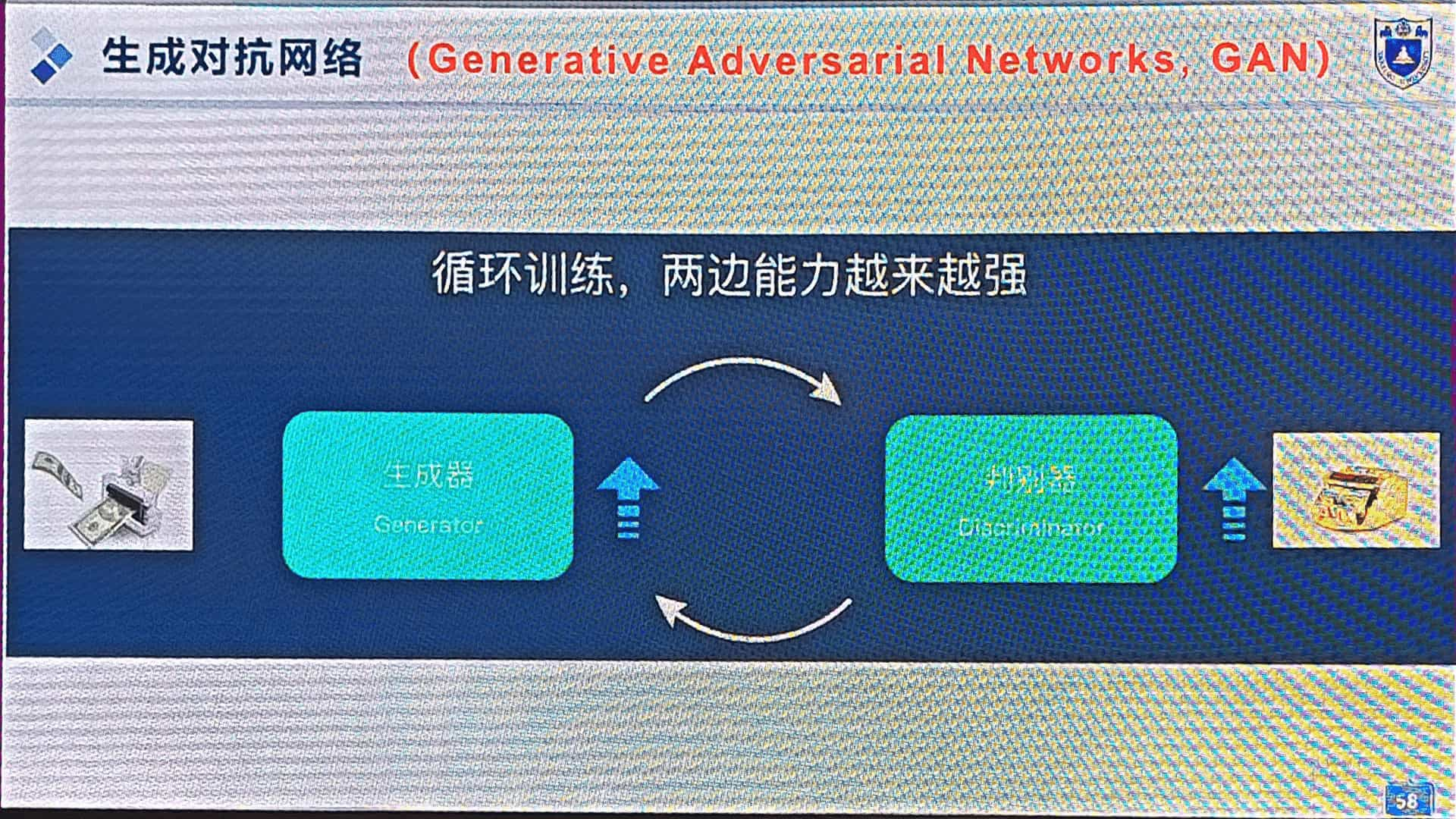

GAN 生成对抗网络:

生成器 vs 判别器(图28)

1. 训练判别器(验钞机),验证图像符合审美标准。

2. 训练生成器:生成图像(假钞),判别器评判,奖惩训练生成器。

3. 训练过程中,双方能力越来越强。

4. 生成器投入生产环境,生成高质量图像。

3. 应用

生成人脸、现实图片、动画角色、图像转换(日转夜、色彩还原)、图像编辑、早期文生图(RNN+GNN,图29)。

4. 挑战

模式坍塌:生成器的功能,从取悦人变为骗过判别器。内容范围少,出现重复图片。(图30)

5. 新的途径:通过复原来创造

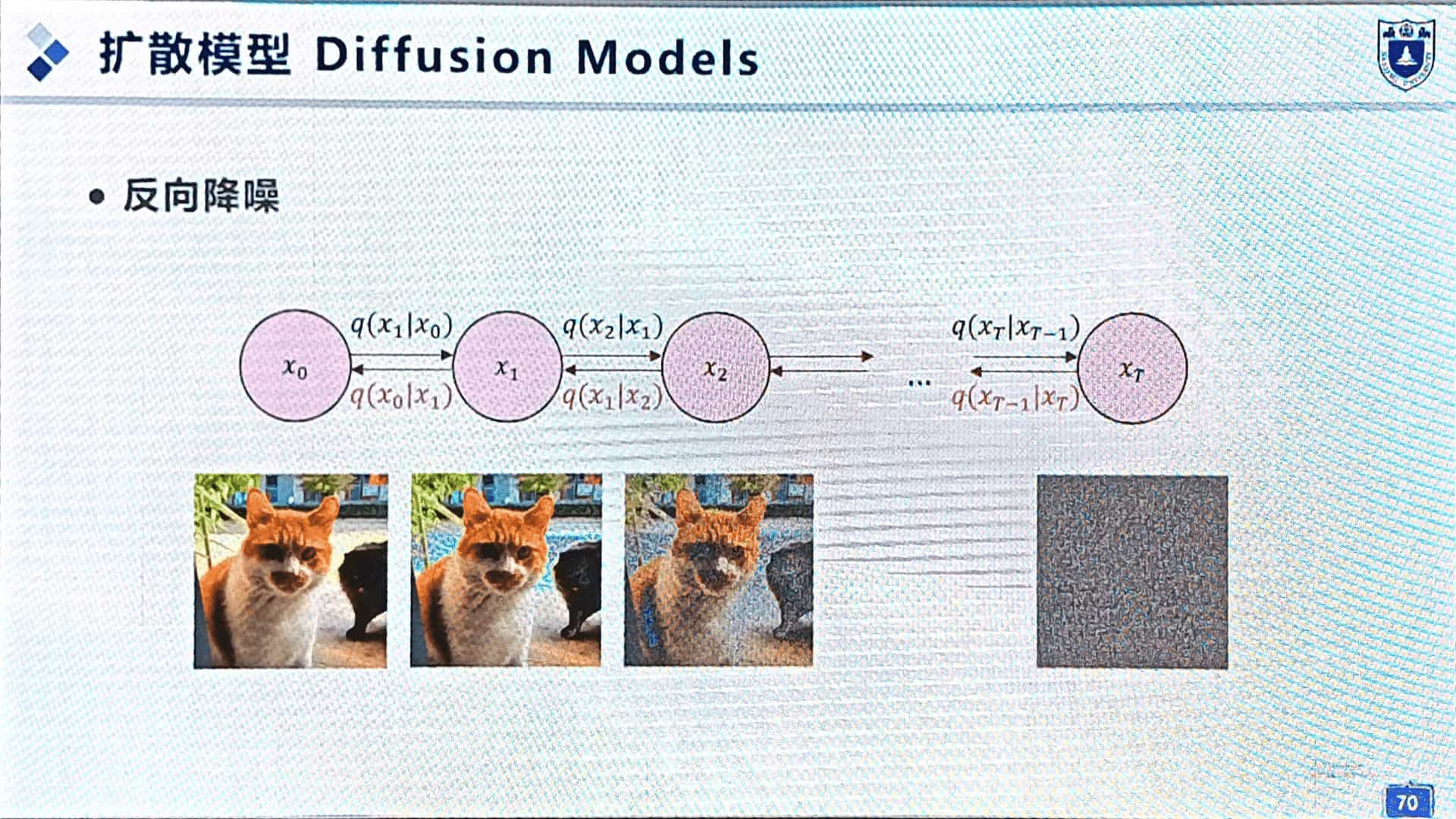

扩散模型:

1. 图像引入噪声,渐渐“扩散”,输入模型完成训练。

2. 模型从全噪声图像开始,反向降噪“复原”,还原为一张图片。(图31)

6. 扩散模型应用

主流文生图、图像擦除,根据布局生成图像(图32)。

7. 机器大脑的创造能力和人类一样?

机器大脑无法做到真正的创新。

例:机器智能从现有训练集中模仿,人类可以创造出前所未有的文字。(图33)

句意理解:机器注意

1. 生物大脑的注意力机制

意识聚焦+信息过滤 → 认知效能↑(图34、图35)

2. 设计具有注意力的机器大脑

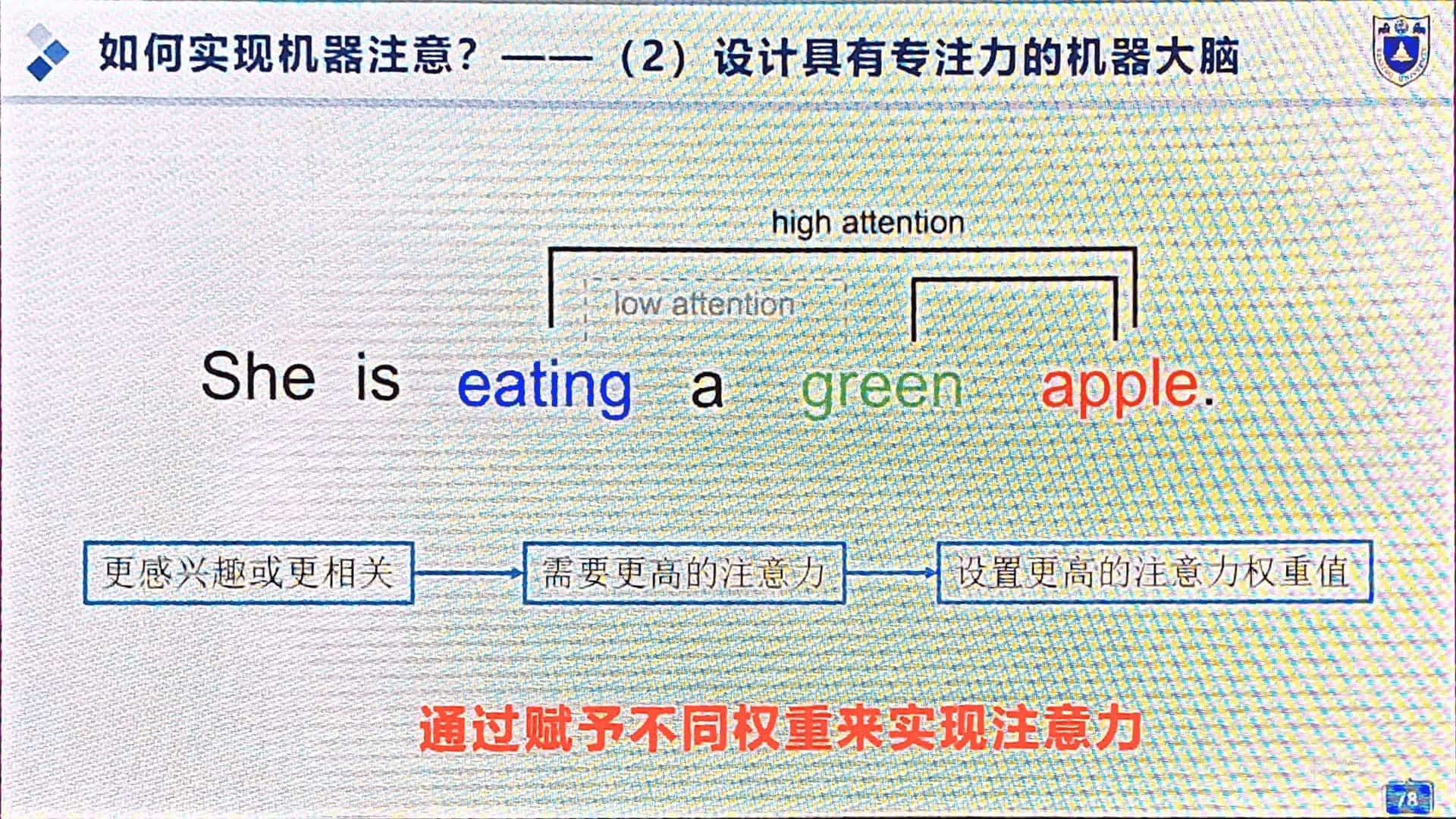

注意力机制:

图36所示,eating 和 green 不相关,设置较低的注意力权重值。

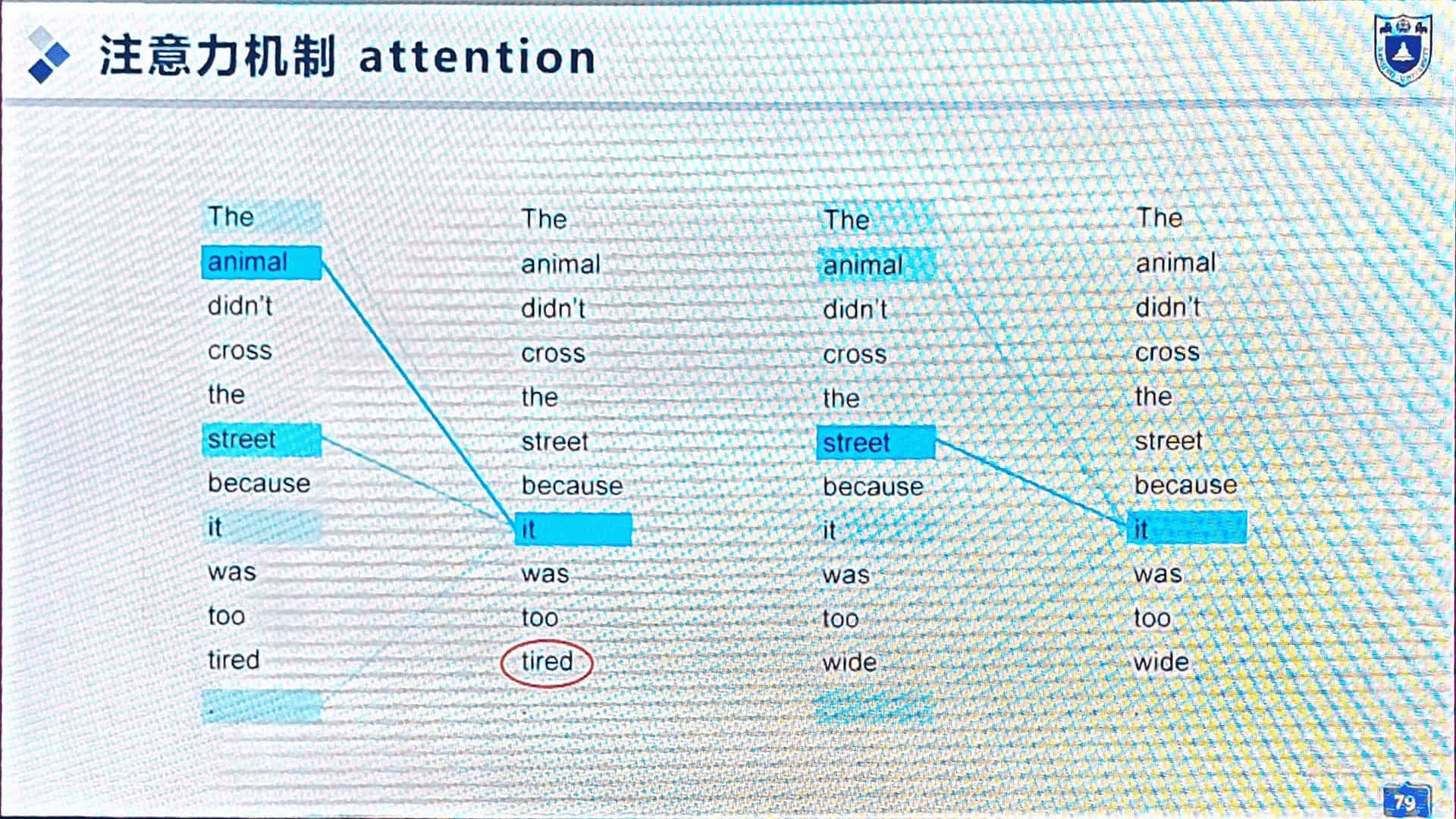

图37所示,更换单词 tired → wide,代词“it”的注意力权重发生改变。

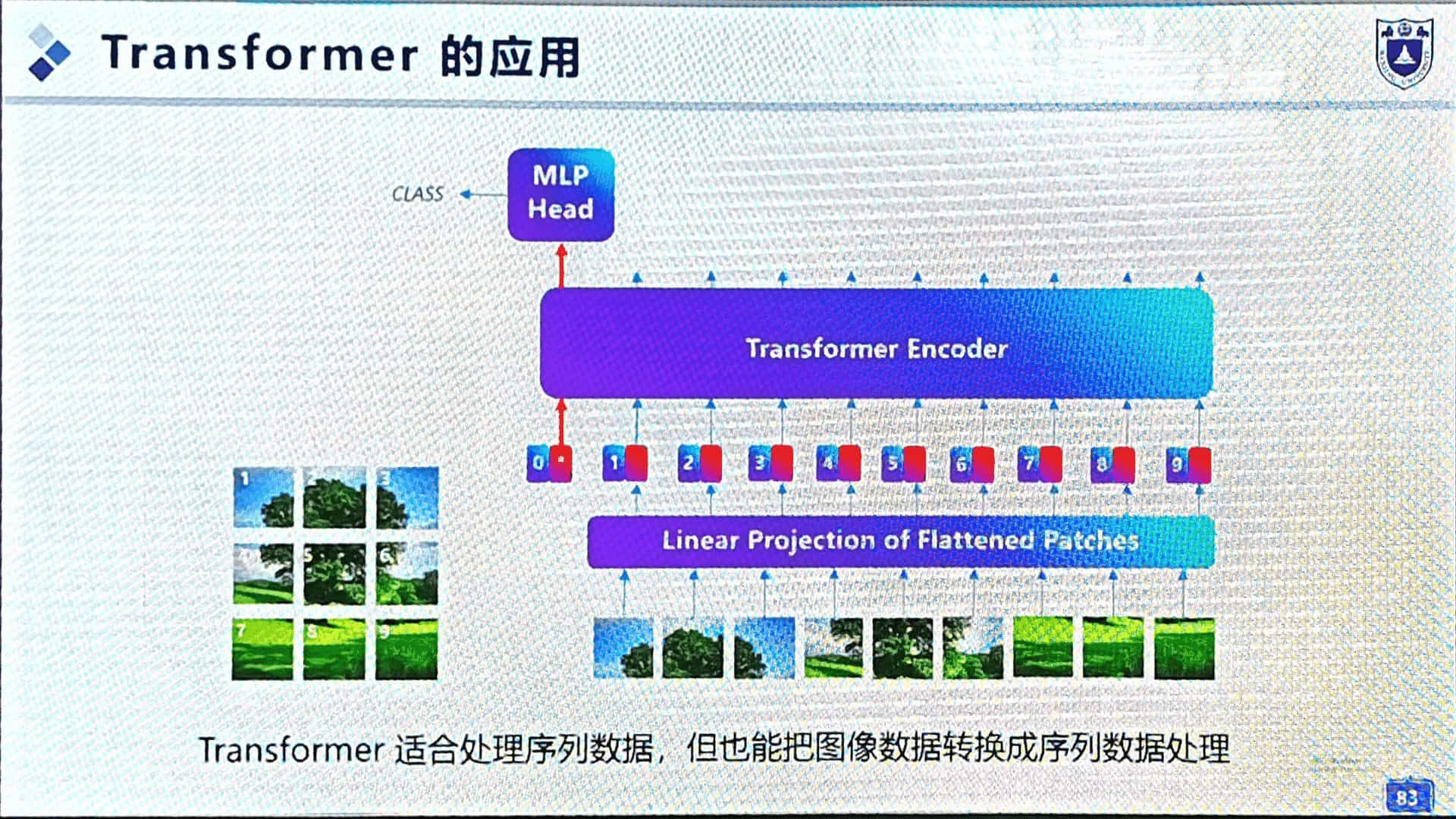

Transformer 模型,全新的架构。没有 RNN 的循环,注意力即是一切。(图38)

多头注意力机制,处理序列数据。(这节课和上一节课都没听懂,“多头”是个什么东西。QWQ)

模型具有了更强的语义理解能力。

3. 应用

与 RNN 一样,适于处理序列数据。(图39)

机器翻译、股价预测。

4. 与人类的差别

机器需要:(1) 海量语言数据;(2) 大量算力。(图40)

人脑的优势:(1) 资源消耗量:几个馒头支撑一天的思考;(2) 感官理解世界,思想、观念。

典型神经网络的应用

这类神经网络很早就开始应用了。

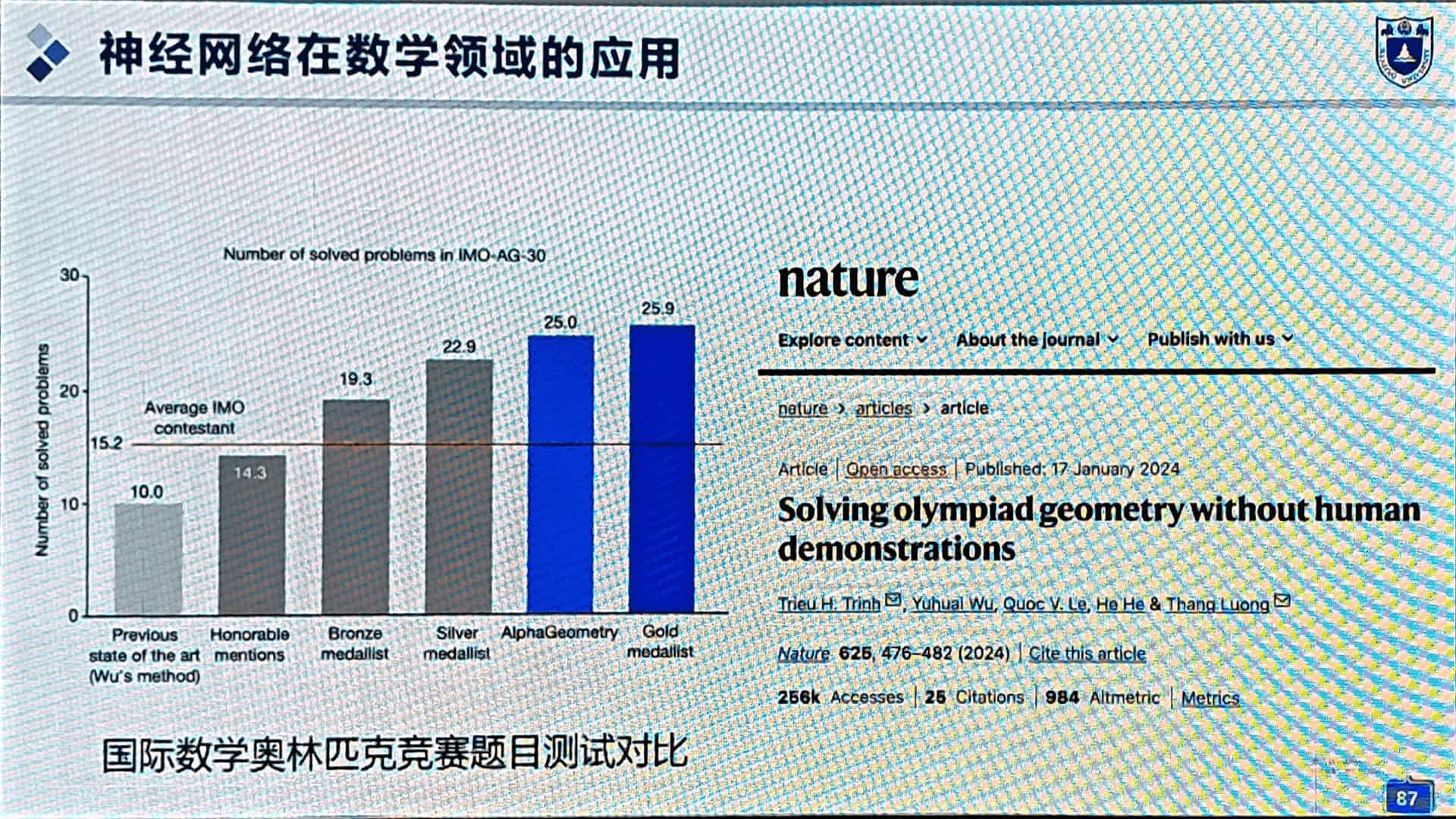

生命科学(图42),竞赛数学(图43,但过时。Google Gemini 在 IMO 2025 达到金牌成绩),大气科学(图44),地球科学(图45)。

三、神经网络大模型及其应用

这部分内容没认真听。

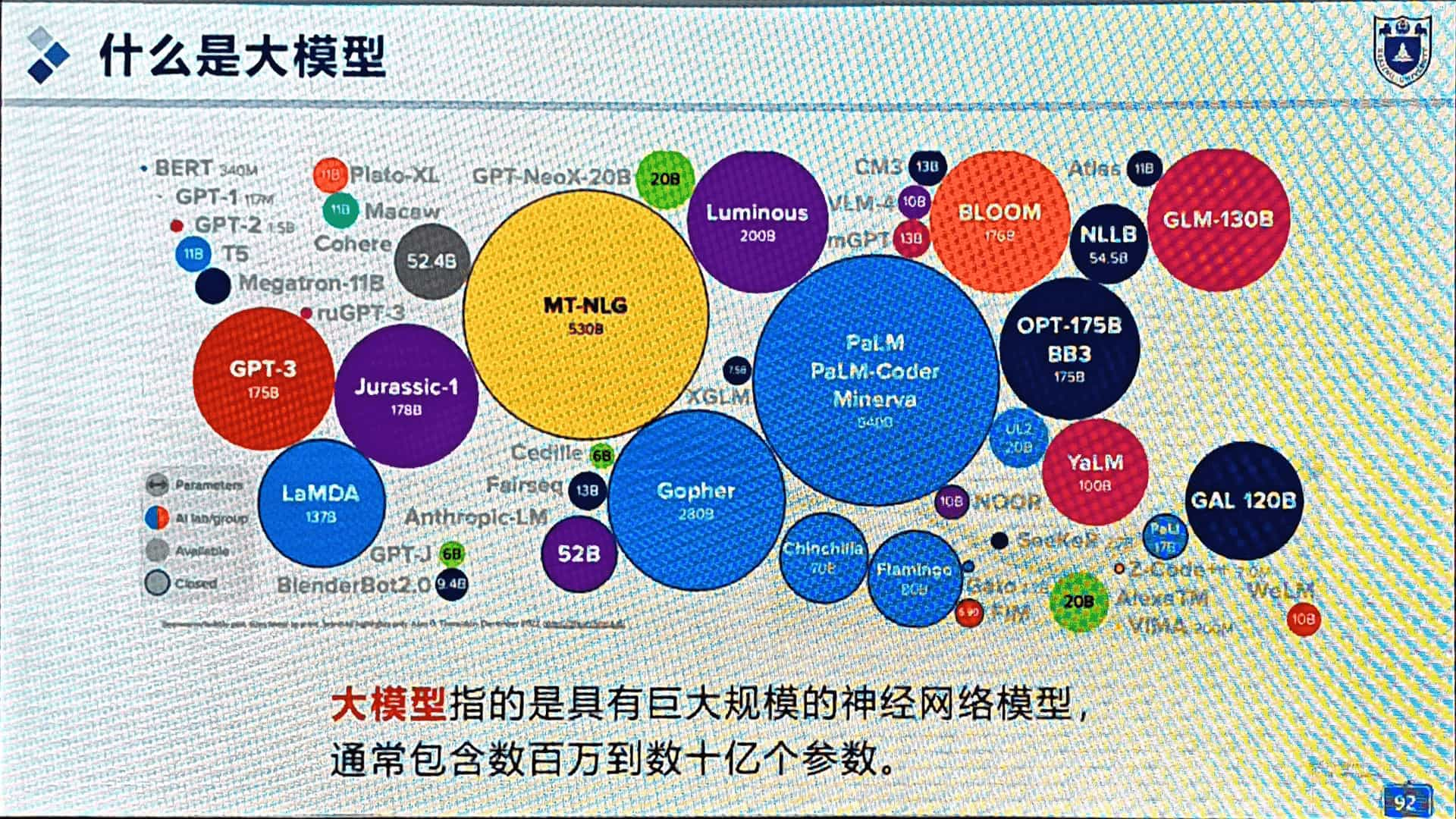

大模型

参数量百万+(图47)

大模型的训练方法:预训练+微调。(图48)

1. 预训练:在海量无标注数据上学习通用知识(如语言规律),构建基础能力。

2. 微调:用特定任务的小规模标注数据调整模型,使其适应具体应用(如问答或翻译)。

量变引起质变。(图49,上节课讲过“智能涌现”)

举例:ChatGPT 文字,Sora 视频,Suno 音乐,EMO。

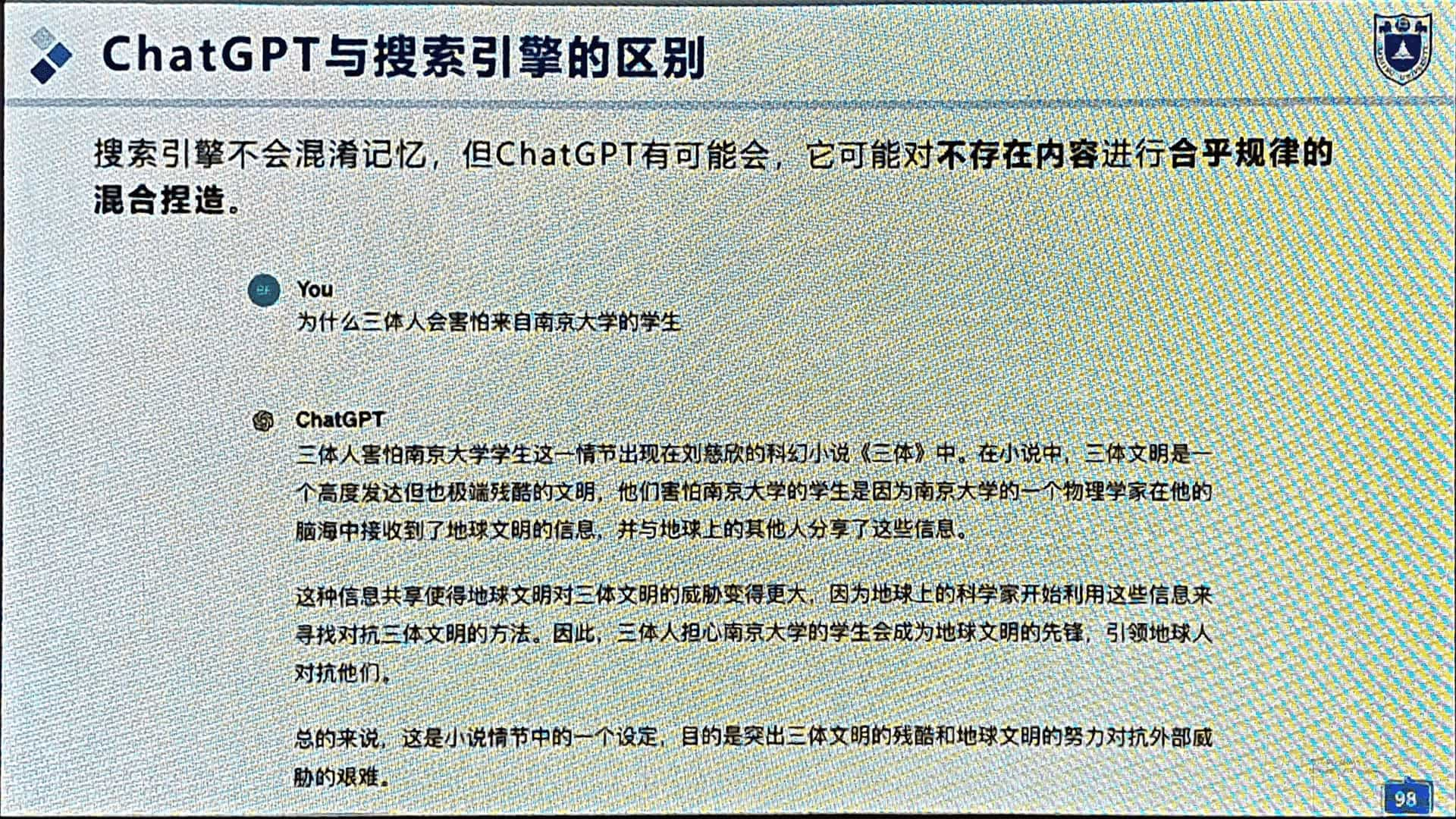

语言大模型

GPT,逐字生成。

应用:(1) 提建议;(2) 学习技能。

DeepSeek:低成本,常规性能。

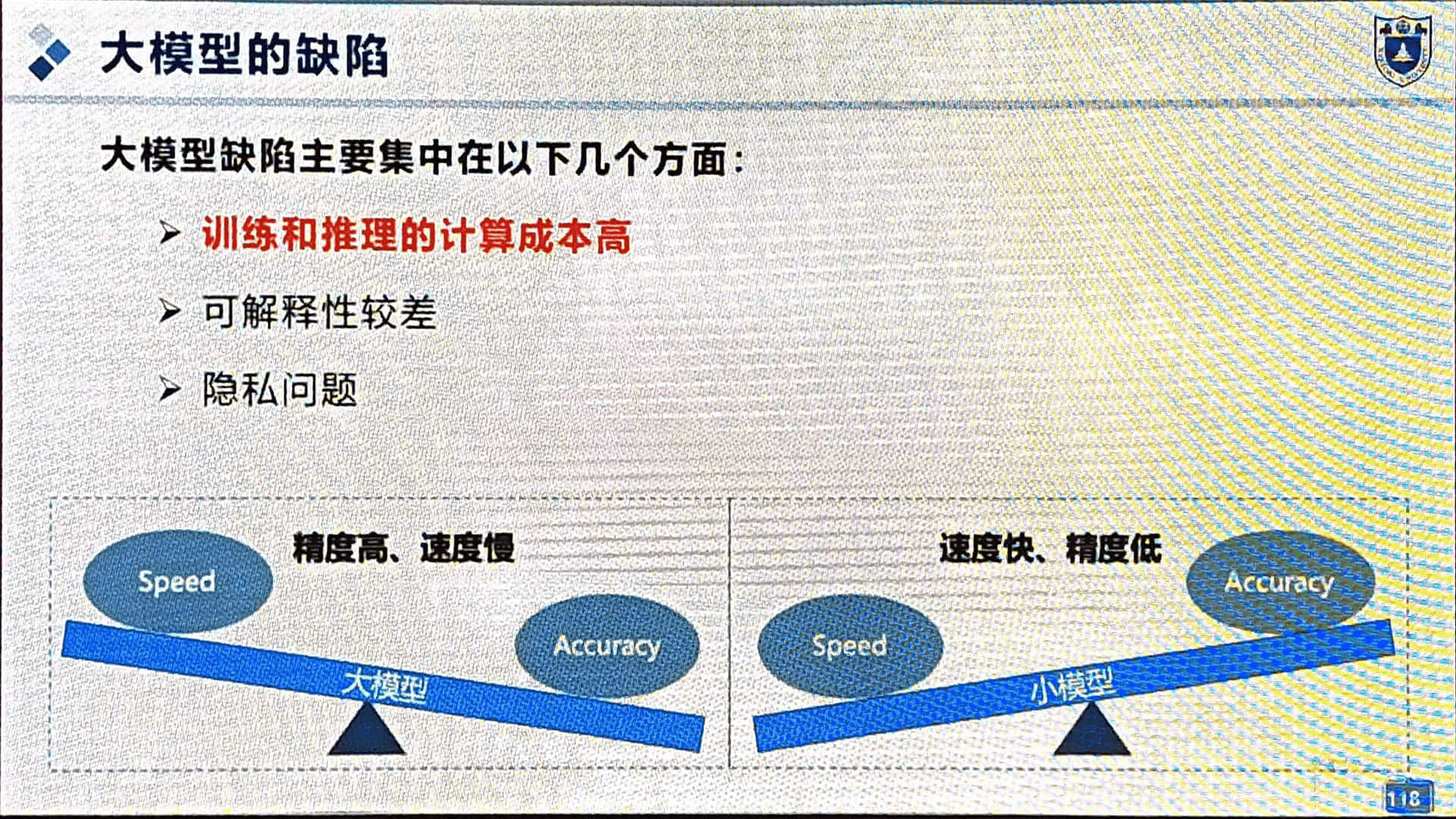

大模型的缺陷

如图。非常喜欢图54。少截一张。

神经网络隐藏层发生了什么,没人知道;出了问题都不知道怎么出的,也不好改。

总结

- 卷积神经网络:模仿人类大脑的抽象思维

- 循环神经网络:模仿人类大脑的记忆能力

- 生成对抗网络与扩散模型:模仿人类大脑的创造力

- 注意力机制与 Transformer:模仿人类大脑的专注力

- 大模型:模仿人类大脑的海量神经元

四、人工智能安全

面临问题:

- 数字人

- 伪造视频

- 伪造新闻

- 变脸换声

- 生成不雅视频

安全属性:

- 可靠性:系统稳定无故障运行。

- 透明性:过程可追溯可审查。

- 可解释性:决策逻辑清晰可理解。

- 公平性:无歧视无偏见。

- 隐私性:数据保护防泄露。

五、机器大脑和人类大脑是一样的吗

区别:

1. 复杂程度 ×3

2. 成长能力:训练好锁定 ↔ 不断成长

3. 可解释性:黑箱 ↔ 问出问题

4. 能量消耗:巨量电力 ↔ 几顿饭

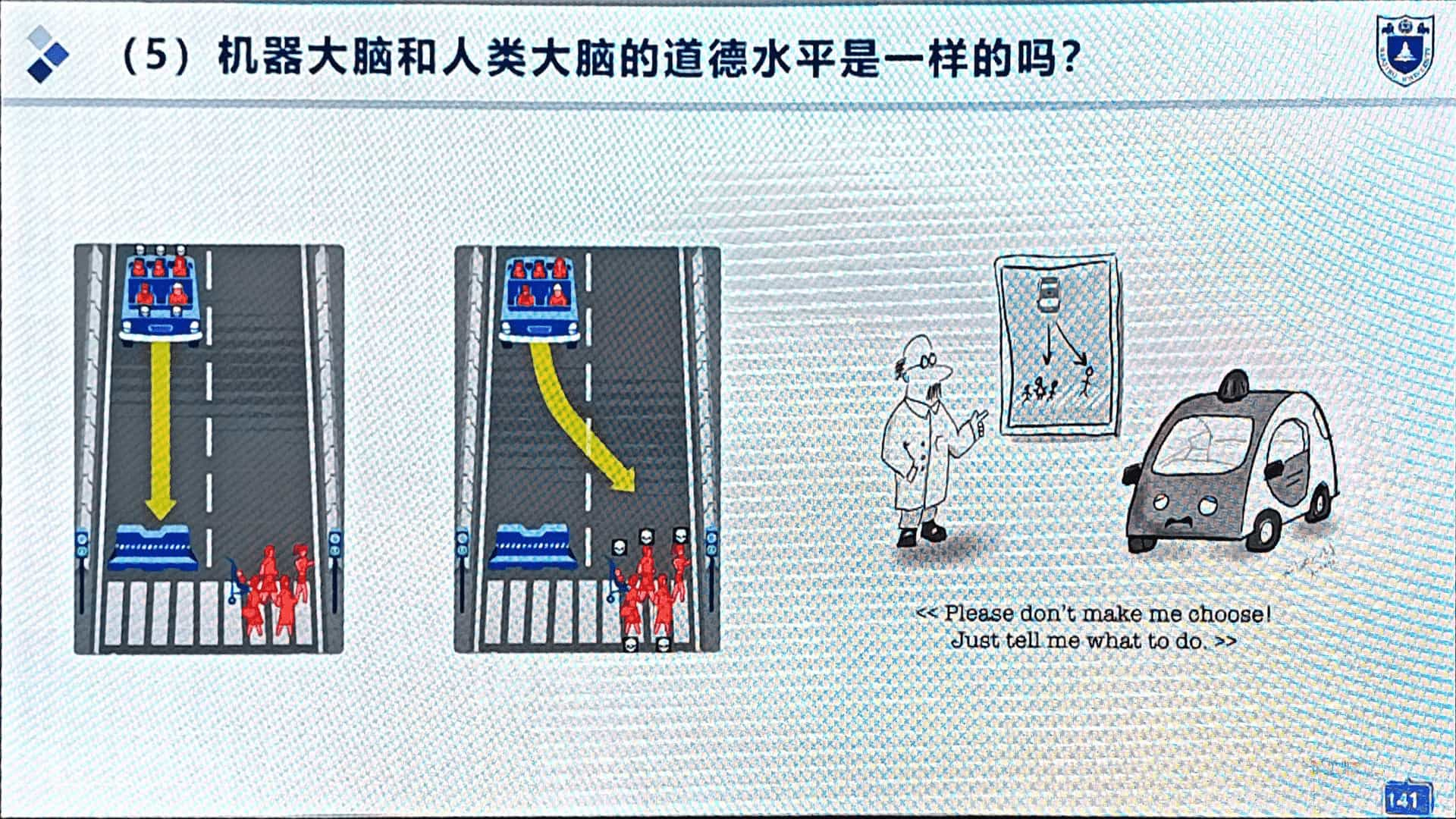

5. 道德水平

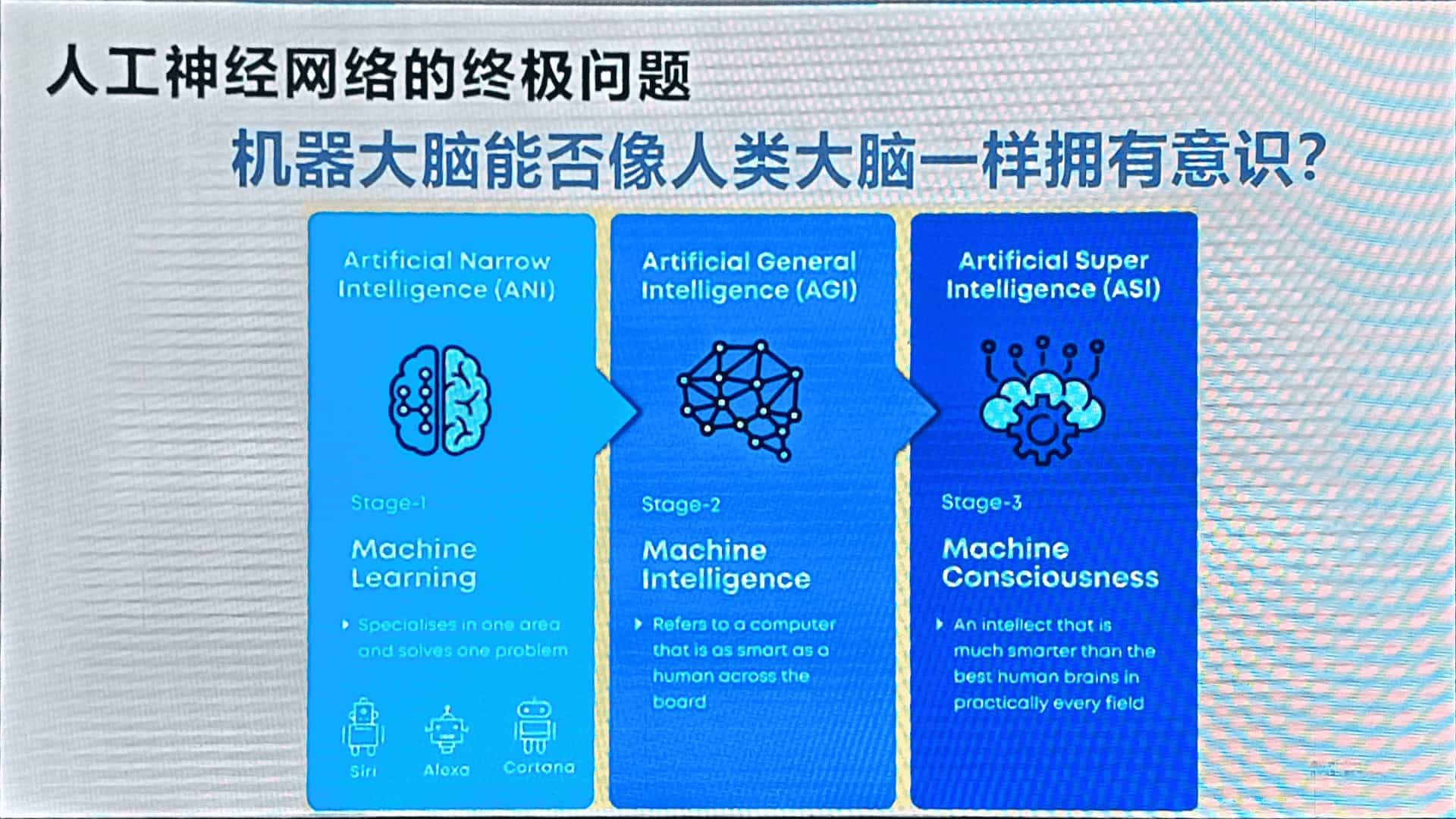

终极问题:机器大脑能否像人类一样拥有意识?

A. 是否允许;B. 能否做到。

未来展望

探讨了一个问题。ASI 人工超级智能:远超人类智力水平的智能系统。

1. 超越人类所有能力:ASI不仅在逻辑推理、学习速度、数据处理等方面超越人类,还可能在创造力、情感理解、战略决策等领域全面碾压人类智力总和。

2. 自主进化能力:可能具备自我改进的递归能力,无需人类干预即可持续升级。

ASI 产生后,人类会不会被迫灭绝?一种观念认为,制造出 ASI 是人类的使命,在那之后就不管了。

当下中美人工智能领域差异:

中:工业生产、场景赋能。

美:金融医疗。

不能说谁好谁差,只讲并驾齐驱。

总结

当下的人工智能,对人类大脑很皮毛、很粗劣的仿制,就有改变社会结构的可能性。可以想象,这个领域的潜力是巨大的,这个学科在人类把大脑研究透之前永不过时。